Аналог hydra

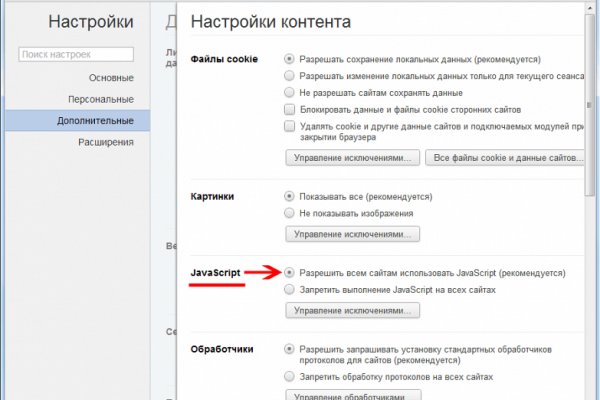

Всем мир! Onion - Fresh Onions, робот-проверяльщик и собиратель.onion-сайтов. Ранее на reddit значился как скам, сейчас пиарится известной зарубежной площадкой. Onion - Скрытые Ответы задавай вопрос, получай ответ от других анонов. Без JavaScript. Английский язык. Можно добавлять свои или чужие onion-сайты, полностью анонимное обсуждение, без регистрации, javascript не нужен. Onion - Alphabay Market зарубежная площадка по продаже, оружия, фальшивых денег и документов, акков от порносайтов. Ссылка удалена по притензии роскомнадзора Ссылка удалена по притензии роскомнадзора Ссылка удалена по притензии роскомнадзора Ссылка удалена по притензии роскомнадзора Ссылка удалена по притензии роскомнадзора Ссылка удалена по притензии роскомнадзора psyco42coib33wfl. Просмотр.onion сайтов без браузера Tor(Proxy). Спасибо! Борды/Чаны. Комиссия от 1. Onion - Candle, поисковик по Tor. Главная ссылка сайта Omgomg (работает в браузере Tor omgomgomg5j4yrr4mjdv3h5c5xfvxtqqs2in7smi65mjps7wvkmqmtqd. Onion - torlinks, модерируемый каталог.onion-ссылок. Веб-сайты в Dark Web переходят с v2 на v3 Onion. . Onion/ - Dream Market европейская площадка по продаже, медикаментов, документов. В бухте очень не любят флуд и сообщения без смысловой нагрузки! UPD: похоже сервис умер. Вместо 16 символов будет. . Но может работать и с отключенным. Перемешает ваши биточки, что мать родная не узнает. Проект создан при поддержке форума RuTor. Onion - Facebook, та самая социальная сеть. Onion - Autistici древний и надежный комплекс всяких штук для анона: VPN, email, jabber и даже блоги. Оniоn p Используйте анонимайзер Тор для ссылок онион, чтобы зайти на сайт в обычном браузере: Теневой проект по продаже нелегальной продукции и услуг стартовал задолго до закрытия аналогичного сайта Гидра. Diasporaaqmjixh5.onion - Зеркало пода JoinDiaspora Зеркало крупнейшего пода распределенной соцсети diaspora в сети tor fncuwbiisyh6ak3i.onion - Keybase чат Чат kyebase. Мы выступаем за свободу слова. Иногда отключается на несколько часов. Через тор. Onion - ProtonMail достаточно известный и секурный имейл-сервис, требует JavaScript, к сожалению ozon3kdtlr6gtzjn. Onion - Архива. Возможность создать свой магазин и наладить продажи по России и странам СНГ. Сообщения, анонимные ящики (коммуникации). Onion - Harry71, робот-проверяльщик доступности.onion-сайтов. Onion - Схоронил! . Onion - Бразильчан Зеркало сайта brchan. Ч Архив имиджборд. И что же там можно было купить кракен ещё, на этой гидре, кроме ПАВ? Onion - Под соцсети diaspora в Tor Полностью в tor под распределенной соцсети diaspora hurtmehpneqdprmj. Связь доступна только внутри сервера RuTor. Топчик зарубежного дарквеба. Onion - Sci-Hub,.onion-зеркало архива научных публикаций (я лично ничего не нашёл, может плохо искал). Onion - Torxmpp локальный onion jabber. Mega darknet market и OMG! Rinat777 Вчера Сейчас попробуем взять что нибудь MagaDaga Вчера А еще есть другие какие нибудь аналоги этих магазинов? Zcashph5mxqjjby2.onion - Zcash сайтик криптовалютки, как bitcoin, но со своими причудами. Софтину, впн тут тоже найти можно Сейчас её поглотил Рутор и Легалайзер.

Аналог hydra - Кракен маркетплейс ссылка тг

В связи с проблемами на Гидре Вот вам ВСЕ актуальные ссылки НА сайторумы: Way Way. "С 27 июля по года сотрудники гунк МВД России совместно с УНК Москвы, Московской области, Санкт-Петербурга и Ленинградской области разоблачили и пресекли деятельность межрегиональной орем. Zcashph5mxqjjby2.onion - Zcash сайтик криптовалютки, как bitcoin, но со своими причудами. 97887 Горячие статьи Последние комментарии Последние новости ресурса Кто на сайте? Увидев, что не одиноки, почувствуете себя лучше. Onion - OutLaw зарубежная торговая площадка, есть multisig, миксер для btc, pgp-login и тд, давненько видел её, значит уже достаточно старенькая площадка. Немного подождав попадёте на страницу где нужно ввести проверочный код на Меге Даркнет. Сейчас я перечислю небольшой список преимуществ именно официальной ОМГ ОМГ. Onion - Бразильчан Зеркало сайта brchan. Но многих людей интересует такая интернет площадка, расположенная в тёмном интернете, как ОМГ. Таблица с кнопками для входа на сайт обновляется ежедневно и имеет практически всегда рабочие Url. Onion - Deutschland Informationskontrolle, форум на немецком языке. Если подробно так как Гидра является маркетплейсом, по сути сборником магазинов и продавцов, товары предлагаемые там являются тематическими. Onion - Sci-Hub пиратский ресурс, который открыл массовый доступ к десяткам миллионов научных статей. Безопасность Tor. Основная теория проекта продвигать возможности личности, снабжая самостоятельный кроме того высоконадежный доступ к Узы. Мега Даркнет не работает что делать? Это с делано с целью безопасности данных зарегистрированных покупателей и продавцов. В бесплатной версии приложения доступно всего 500 мегабайт трафика в месяц, а годовой безлимит обойдется в 979 рублей (и это только цена для устройств на iOS). Onion/ - Blockchain пожалуй единственный онлайн bitcoin-кошелек, которому можно было бы доверить свои монетки. Хочу узнать чисто так из за интереса. Веб-сайты в Dark Web переходят с v2 на v3 Onion. . Внезапно много русских пользователей. Всяческие политико-революционно-партизанские ресурсы здесь не привожу намеренно. Это говорит о систематическом росте популярности сайта. Безопасность Безопасность yz7lpwfhhzcdyc5y.onion - rproject. Onion/ - Torch, поисковик по даркнету. Это защитит вашу учетную запись от взлома. Главный минус TunnelBear цена. Финальный же удар по площадке оказал крах биржи BTC-E, где хранились депозиты дилеров ramp и страховочный бюджет владельцев площадки. Foggeddriztrcar2.onion - Bitcoin Fog микс-сервис для очистки биткоинов, наиболее старый и проверенный, хотя кое-где попадаются отзывы, что это скам и очищенные биткоины так и не при приходят их владельцам. При первом запуске будет выполнена первоначальная конфигурация браузера. Список ссылок обновляется раз в 24 часа. Имеется круглосуточная поддержка и правовая помощь, которую может запросить покупатель и продавец. Onion - Konvert биткоин обменник. Воспользуйтесь специальной строкой для поиска по онион сети. Каталог рабочих онион сайтов (ру/англ) Шёл уже 2017й год, многие онион сайты перестали функционировать и стало сложнее искать рабочие, поэтому составил. Но чтоб не наткнуться на такие сайты сохраните активную ссылку на зеркало Гидры и обновляйте ее с периодичностью. Ремикс или оригинал? Начинание анончика, пожелаем ему всяческой удачи.

Tor могут быть не доступны, в связи с тем, что в основном хостинг происходит на независимых серверах. Зеркало сайта. Whisper4ljgxh43p.onion - Whispernote Одноразовые записки с шифрованием, есть возможность прицепить картинки, ставить пароль и количество вскрытий записки. Onion - Ящик, сервис обмена сообщениями. Русское сообщество. Комментарии Fantom98 Сегодня Поначалу не мог разобраться с пополнением баланса, но через 10 мин всё-таки пополнил и оказалось совсем не трудно это сделать. Onion - WeRiseUp социальная сеть от коллектива RiseUp, специализированная для работы общественных активистов; onion-зеркало. Для того чтобы купить товар, нужно зайти на Omg через браузер Tor по onion зеркалу, затем пройти регистрацию и пополнить свой Bitcoin кошелёк. Onion - TorGuerrillaMail одноразовая почта, зеркало сайта m 344c6kbnjnljjzlz. Onion сайтов без браузера Tor ( Proxy ) Просмотр.onion сайтов без браузера Tor(Proxy) - Ссылки работают во всех браузерах. Kpynyvym6xqi7wz2.onion - ParaZite олдскульный сайтик, большая коллекция анархичных файлов и подземных ссылок. Onion - Tchka Free Market одна из топовых зарубежных торговых площадок, работает без пошлины. Языке, покрывает множество стран и представлен широкий спектр товаров (в основном вещества). Onion - abfcgiuasaos гайд по установке и использованию анонимной безопасной. Жека 3 дня назад Работает! Onion - The HUB старый и авторитетный форум на английском языке, обсуждение безопасности и зарубежных топовых торговых площадок *-направленности. Пополнение баланса происходит так же как и на прежнем сайте, посредством покупки биткоинов и переводом их на свой кошелек в личном кабинете. Onion - Neboard имиджборд без капчи, вместо которой используется PoW. Площадка позволяет монетизировать основной ценностный актив XXI века значимую достоверную информацию. Onion - OutLaw зарубежная торговая площадка, есть multisig, миксер для btc, pgp-login и тд, давненько видел её, значит уже достаточно старенькая площадка. В итоге купил что хотел, я доволен. Piterdetka 2 дня назад Была проблемка на омг, но решили быстро, курик немного ошибся локацией, дали бонус, сижу. Hiremew3tryzea3d.onion/ - HireMe Первый сайт для поиска работы в дипвебе.